谷歌发布TranslateGemma:55种语言翻译新突破,4B至27B模型任选

创始人

2026-01-16 07:24:56

0次

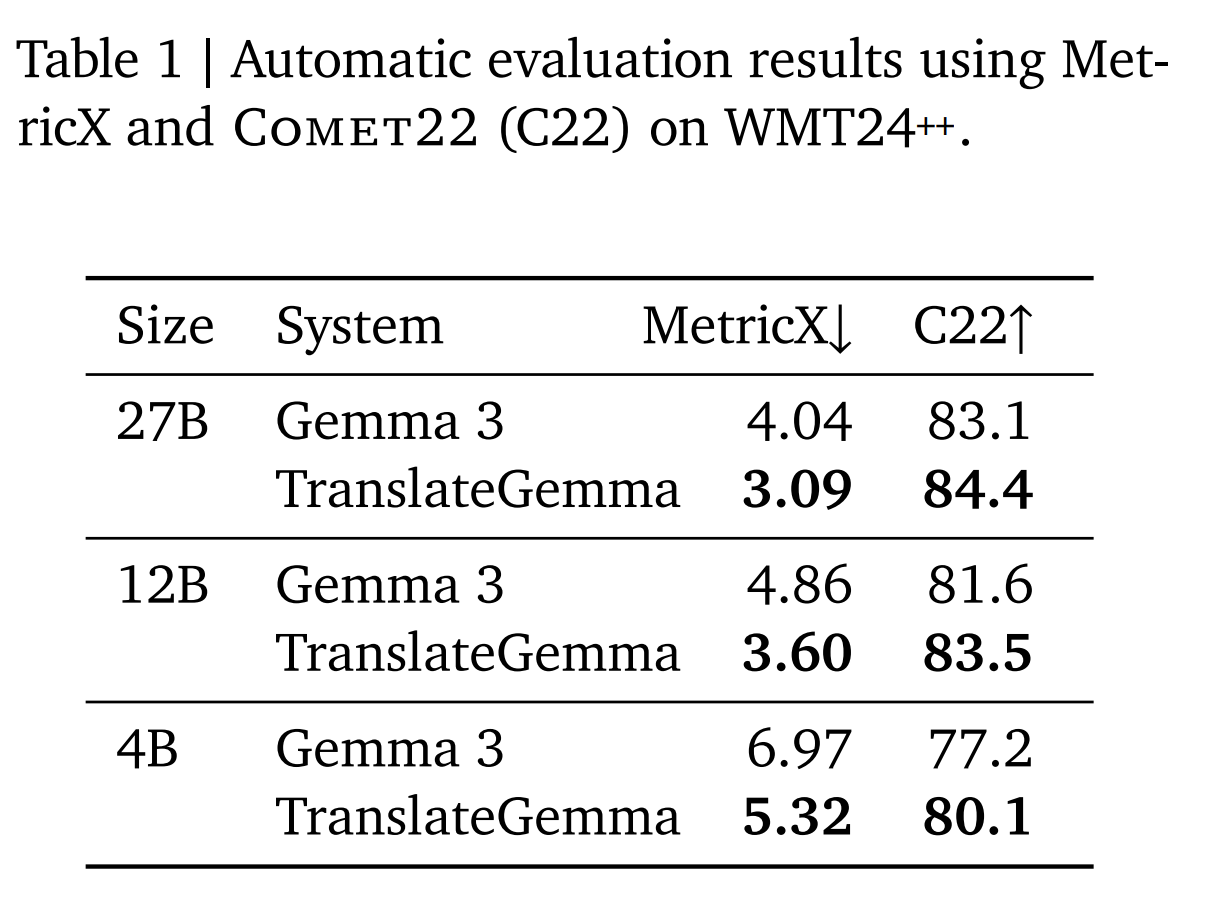

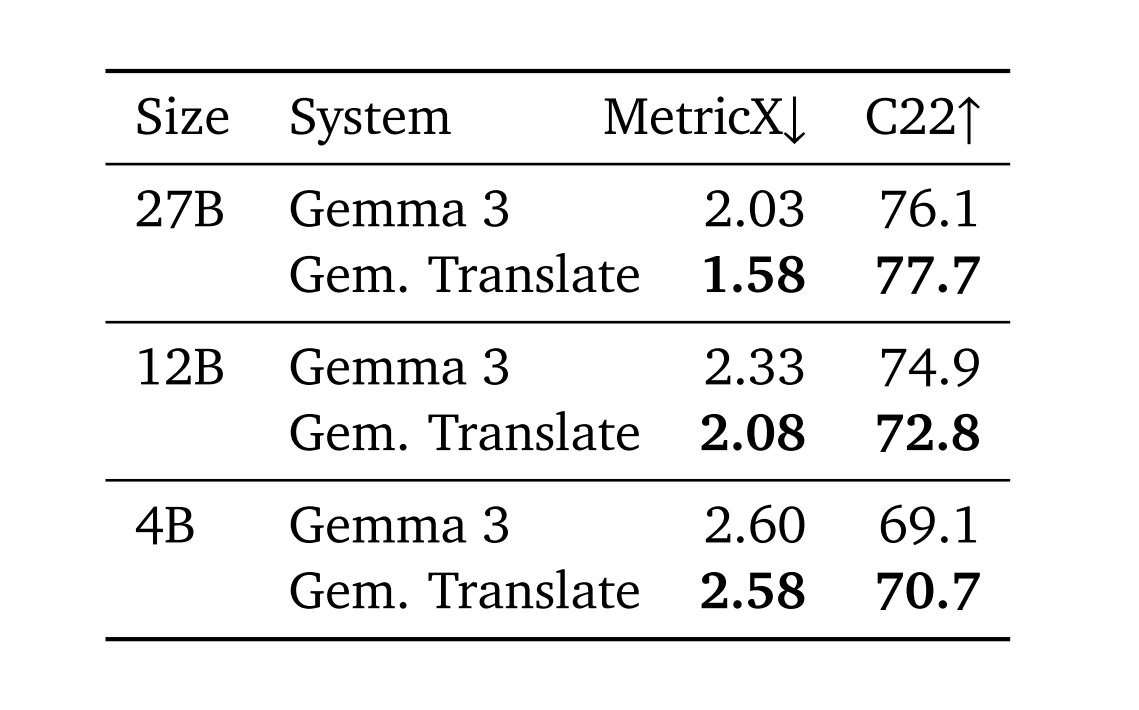

1月15日,谷歌宣布推出基于Gemma3架构的TranslateGemma开放翻译模型系列,包含4B、12B和27B三种参数规模。这些模型支持55种核心语言及多模态图像翻译,并已在Kaggle和HuggingFace开放下载。性能测试显示,TranslateGemma12B版本的翻译质量超越了参数量大其两倍的Gemma327B基线模型,意味着开发者可以以更低的算力资源获得更高保真的翻译结果,提升吞吐量并降低延迟。同时,4B模型也展现出与12B基线模型相当的性能,为移动端和边缘计算设备提供了强大的翻译能力。

TranslateGemma的技术优势在于其独特的“两阶段微调”工艺,包括监督微调(SFT)和强化学习(RL)阶段。在语言覆盖方面,模型重点优化并验证了55种核心语言,并探索训练近500种语言,为学术界研究濒危语言提供了基础。得益于Gemma3架构,新模型保留了多模态能力,无需额外针对视觉任务进行微调,其在文本翻译上的提升直接增强了图像内文字的翻译效果。

TranslateGemma的三种尺寸模型对应不同的部署场景:4B模型专为手机和边缘设备优化,12B模型适配消费级笔记本电脑,27B模型则面向追求极致质量的场景。所有模型均已在Kaggle、HuggingFace及VertexAI上线。

相关内容

热门资讯

长城V9X旗舰SUV发布:魏建...

3月5日,长城汽车旗下豪华SUV品牌魏牌(WEY)宣布,长城汽车董事长魏建军成为其旗舰SUV车型V9...

惊蛰食“笋嘢”!一口咬住好春光...

岭南的春风,来得早些掠过木棉枝头,染一树殷红如霞似火,浸在水汽里也不失热烈噼啪落下的雨是惊蛰的前奏沉...

“鸿蒙智行S800轿车72.8...

3月5日,鸿蒙智行尊界S800轿车正式亮相,搭载新一代896线双光路图像级激光雷达,车型开放下定选配...

2026年经济增长预期目标是4...

十四届全国人大四次会议5日上午在人民大会堂开幕,习近平等党和国家领导人出席开幕会,国务院总理李强向大...

为丰富发展人类政治文明作出重要...

“十五五”规划建议明确提出,坚定不移走中国特色社会主义政治发展道路,坚持党的领导、人民当家作主、依法...

我的铁路风景|因为有“你”,旅...

春潮涌动,万象更新旅客跨越山海的奔赴藏着远方的梦想彰显生活的百态“我的铁路风景”主题宣传活动正在火热...

岚图泰山技术焕新,首款四激光量...

今日,岚图汽车官方微博宣布,将举办名为《远见》的岚图泰山技术焕新发布会直播,宣传图透露,岚图汽车将带...

厄瓜多尔留学生与全国人大代表,...

被誉为“中国四大南药”之一的化橘红至今已有1600多年种植历史。这种主要产于广东的珍贵药材,因其独特...

感知中国式现代化的万千气象(和...

中国“一张蓝图绘到底”“一茬接着一茬干”的战略定力,在当前发展挑战不断增多的时代背景下具有跨越国界的...

向着美好未来接续奋斗——全国两...

春潮涌动,万象更新,2026年全国两会大幕开启。这一年,“十五五”开局起步,中国共产党迎来成立105...